禁止别人调试自己前端代码的 5 种方法

禁止别人调试自己前端代码的 5 种方法

本文转自 Toypipi 并作补充

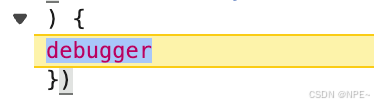

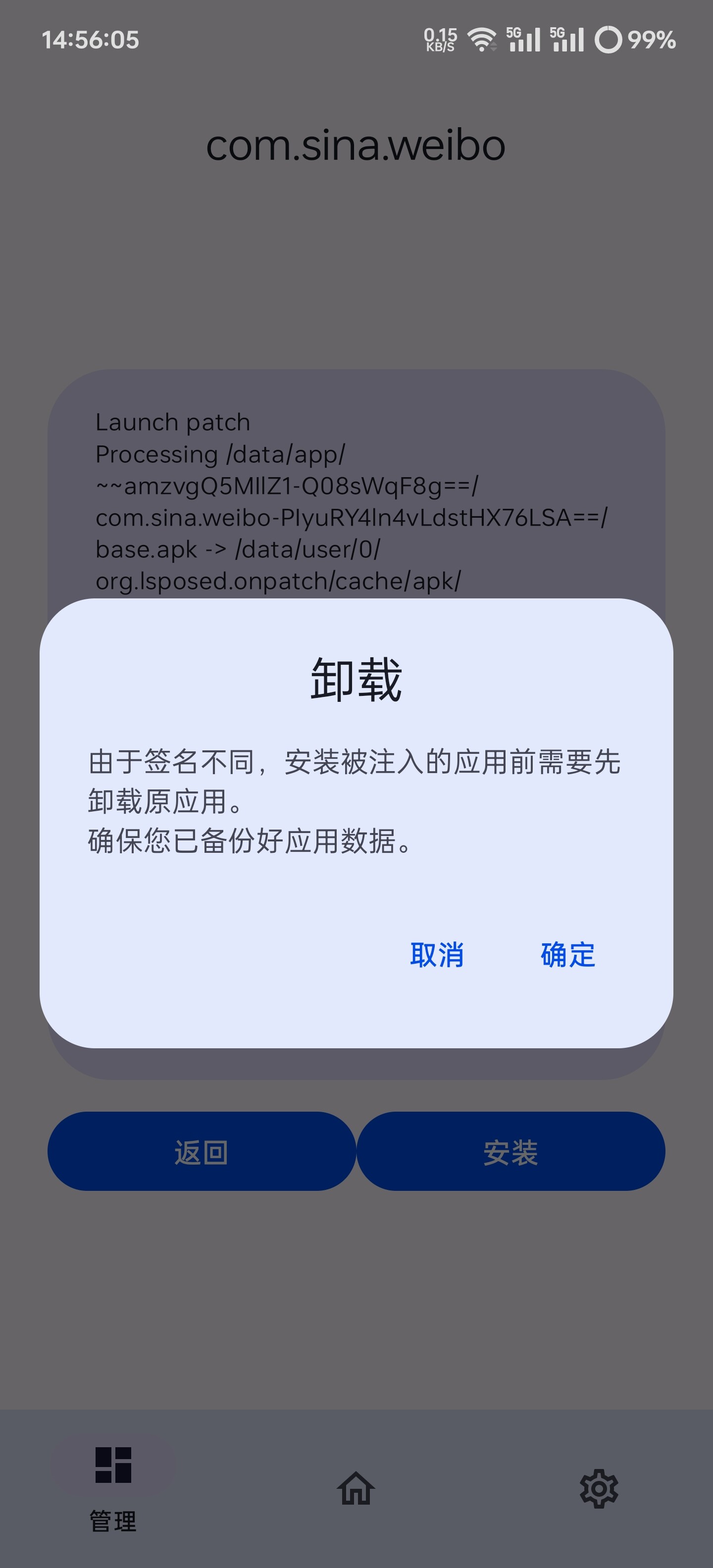

无限 debugger

前端页面防止调试的方法主要是通过不断 debugger 来疯狂输出断点,因为 debugger 在控制台被打开的时候就会执行。由于程序被 debugger 阻止,所以无法进行断点调试,所以网页的请求也是看不到的。 以下是使用无限 debugger 方式阻止代码调试的示例:

2

3

4

5

6

7

8

9

10

11

12

13

* 基础禁止调试代码

*/

(() => {

function ban() {

setInterval(() => {

debugger;

}, 50);

}

try {

ban();

} catch (err) {}

})();不过,如果仅仅是加上面那么简单的代码,对于一些技术人员而言作用不大。可以通过控制台中的 Deactivate breakpoints 按钮或者使用快捷键 Ctrl + F8 关闭无限 debugger。这种方式虽然能去掉碍眼的 debugger,但是无法通过左侧的行号添加 breakpoint。

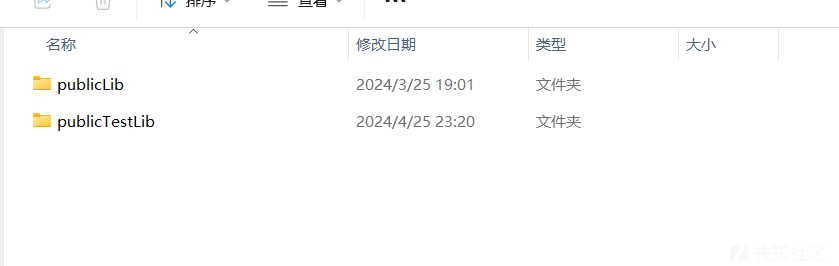

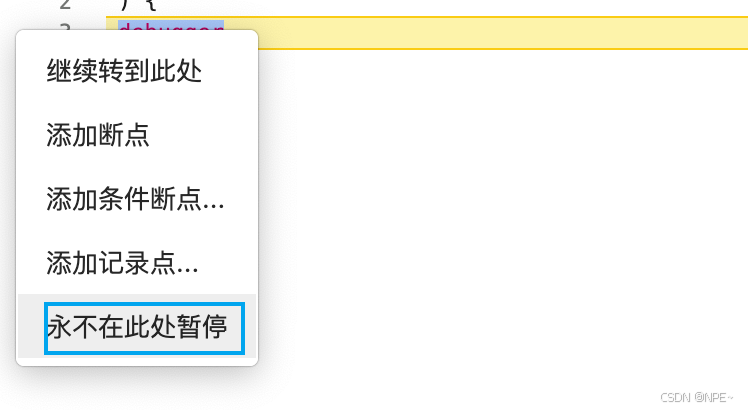

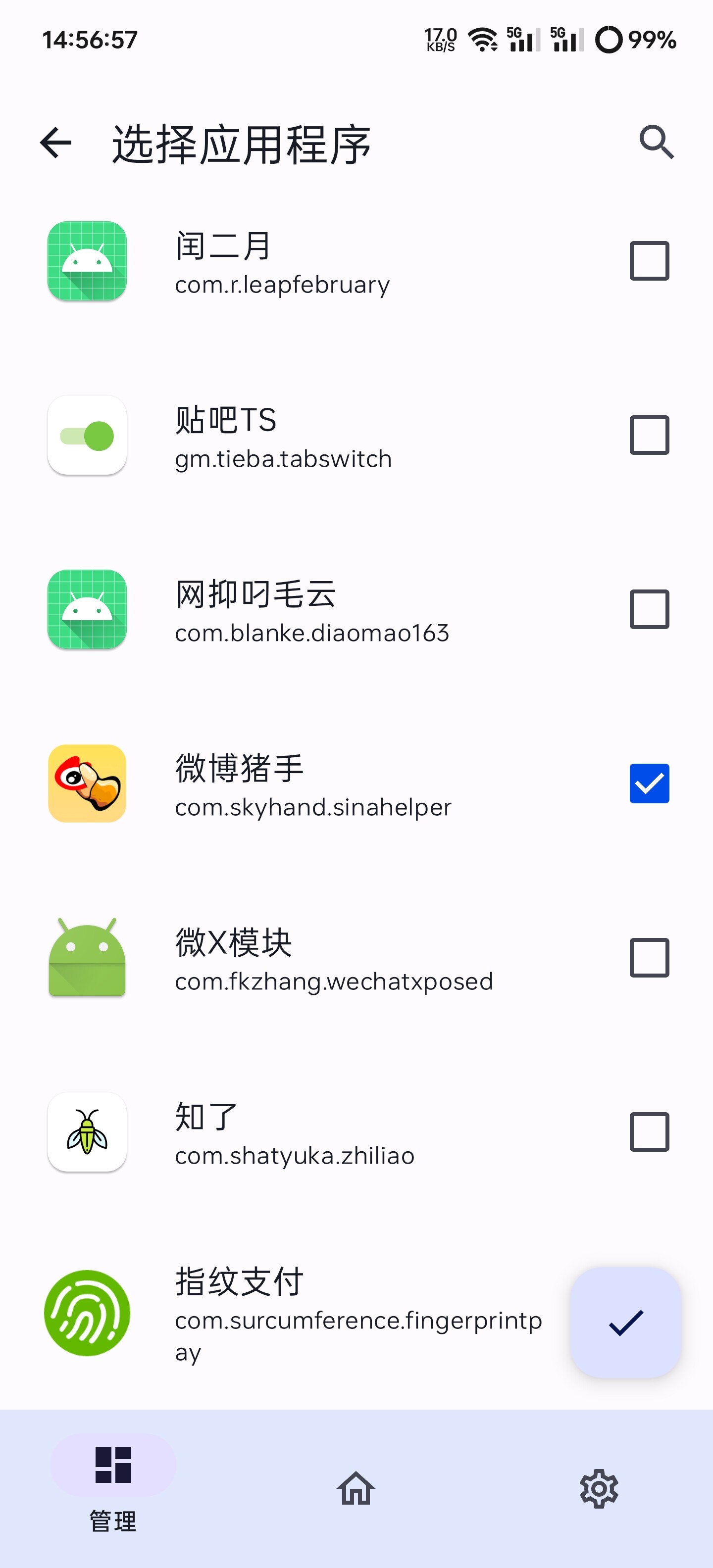

禁止断点的对策

如果将 setInterval 中的代码写在一行,就能禁止用户断点,即使添加 logpoint 为 false 也无用。当然即使有些人想到用左下角的格式化代码,将其变成多行也是没用的。

2

3

4

5

6

7

8

9

10

function ban() {

setInterval(() => {

debugger;

}, 50);

}

try {

ban();

} catch (err) {}

})();

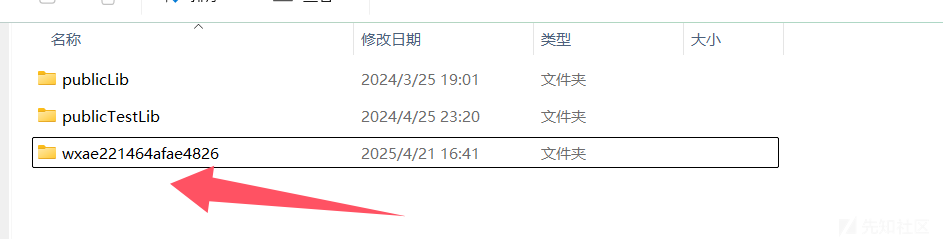

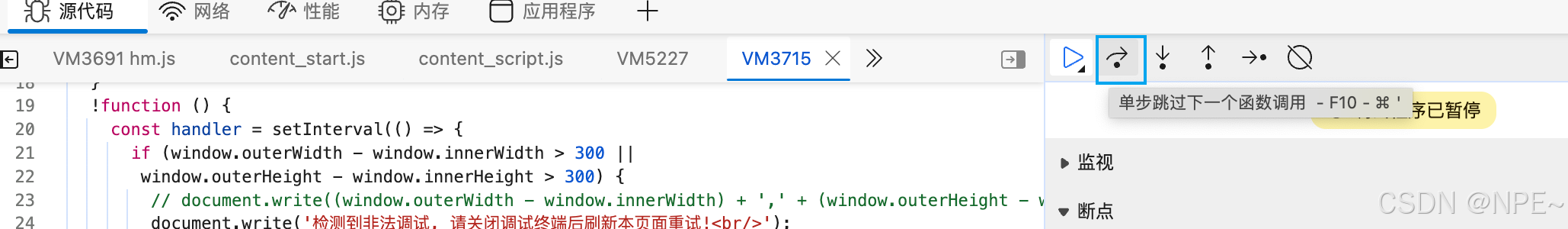

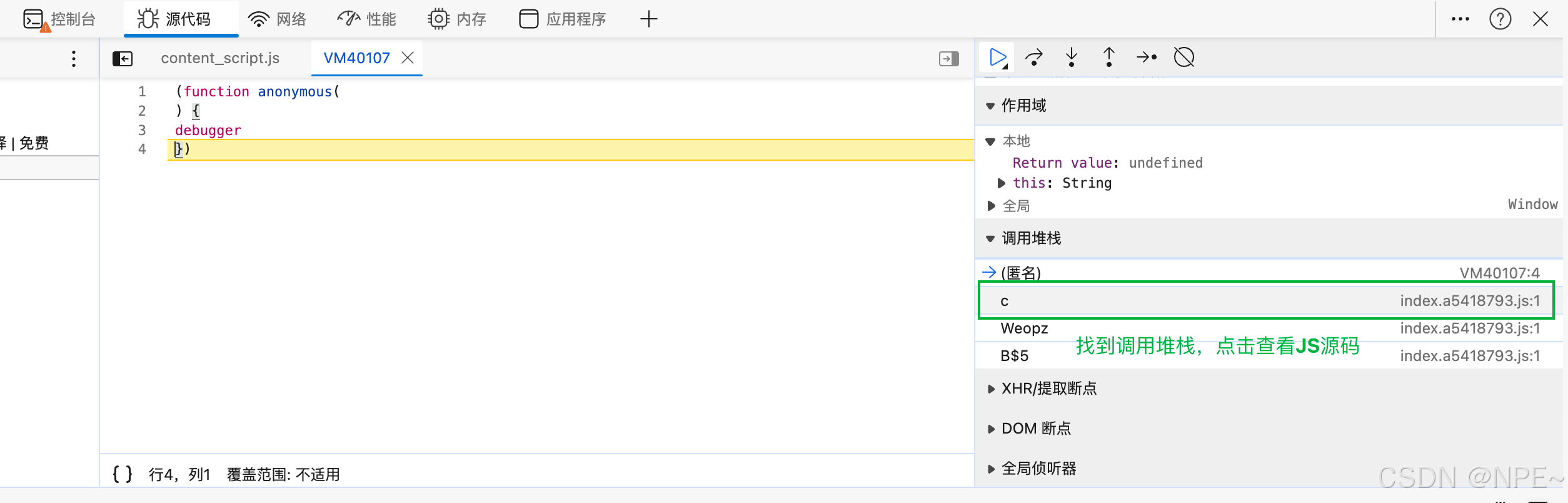

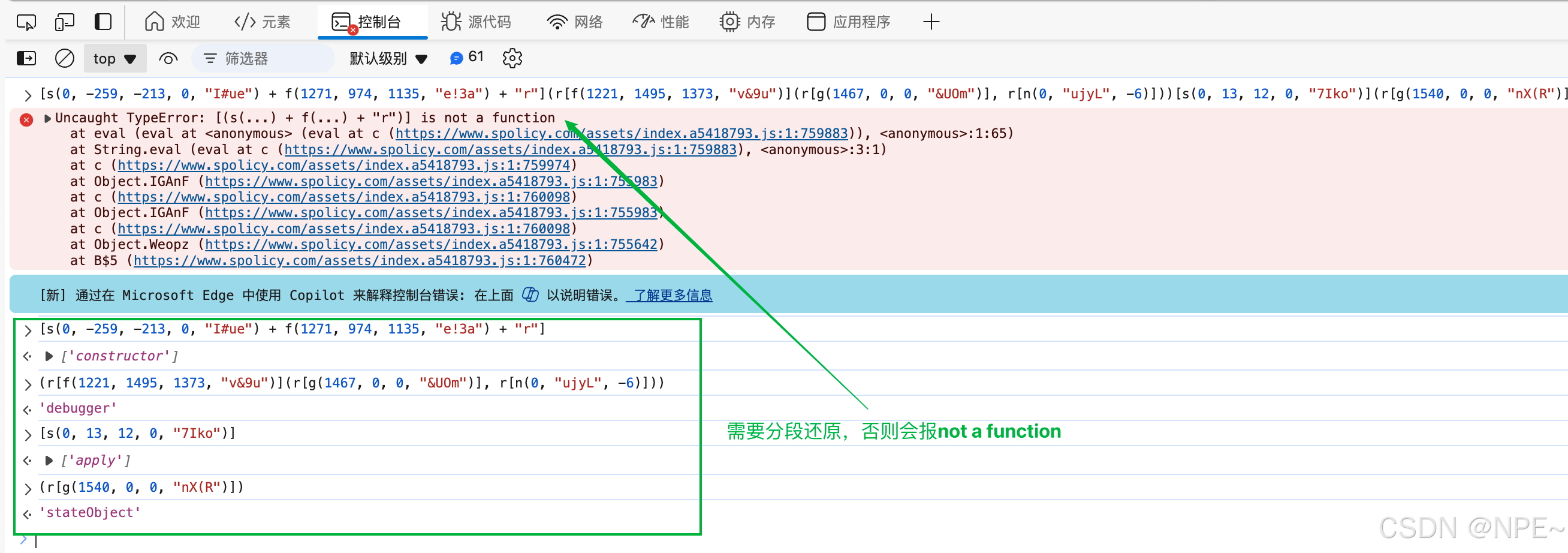

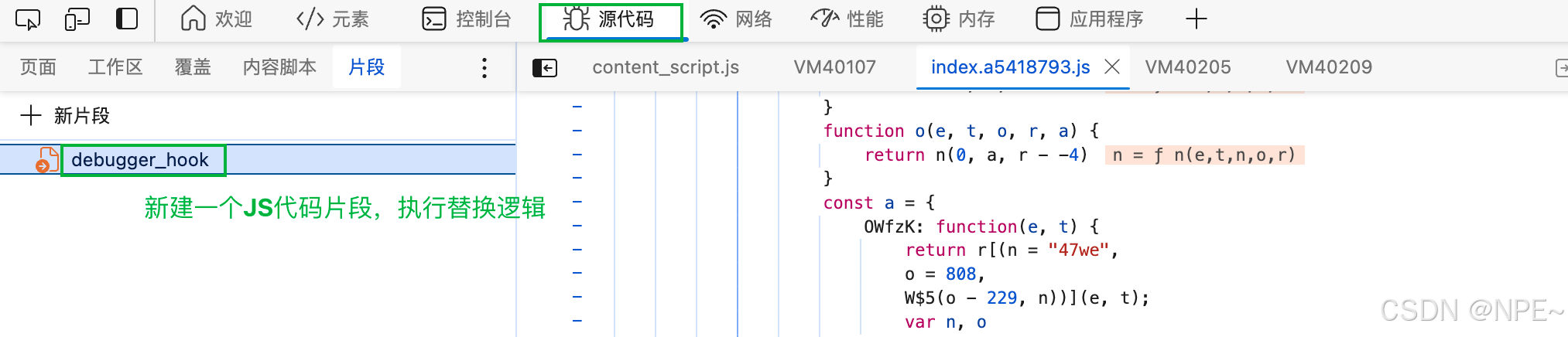

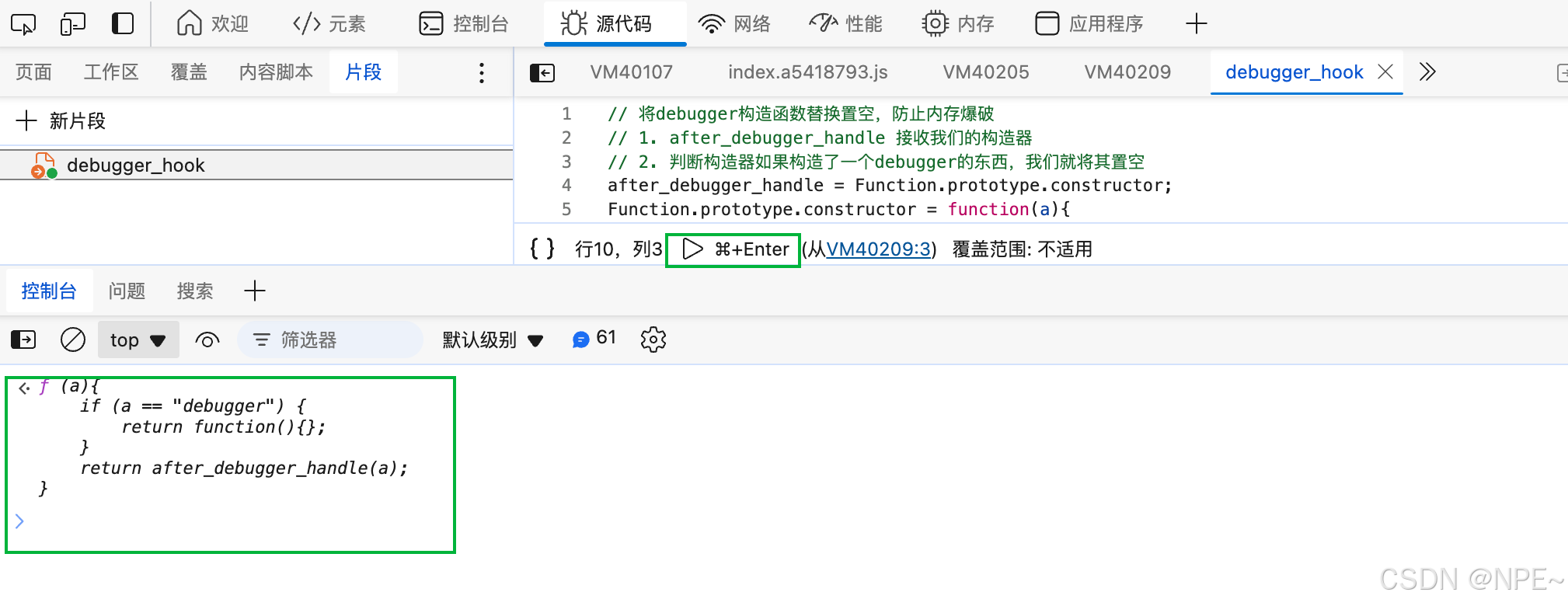

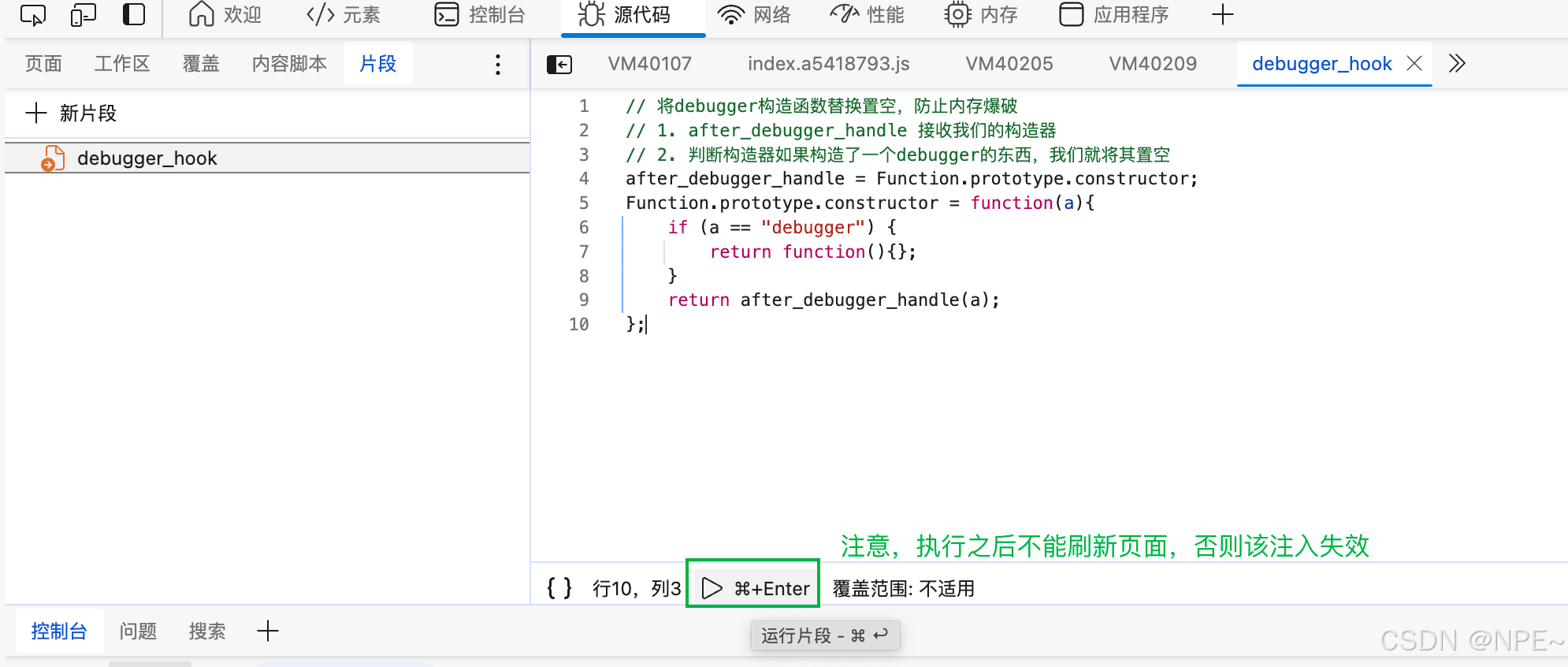

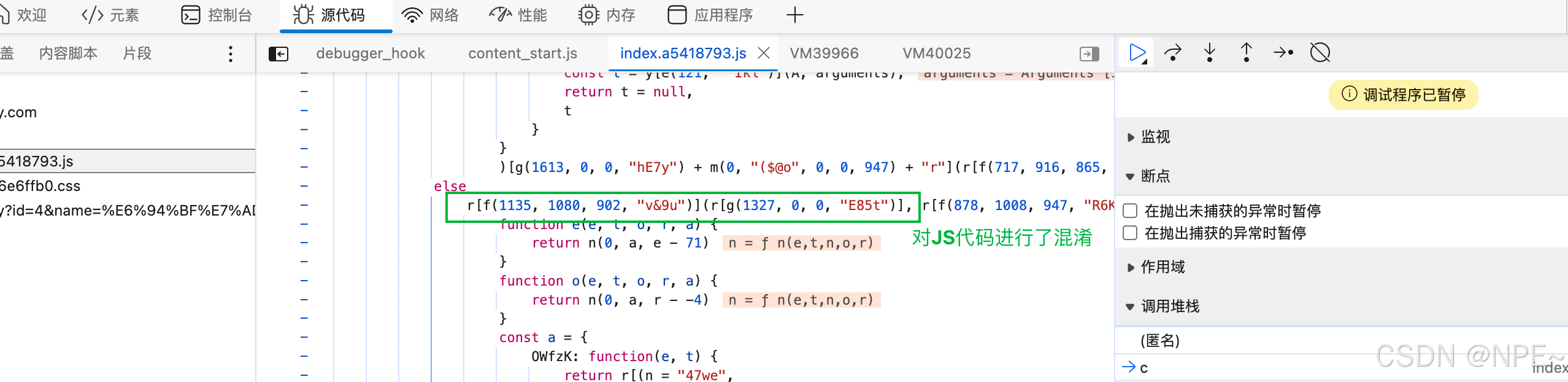

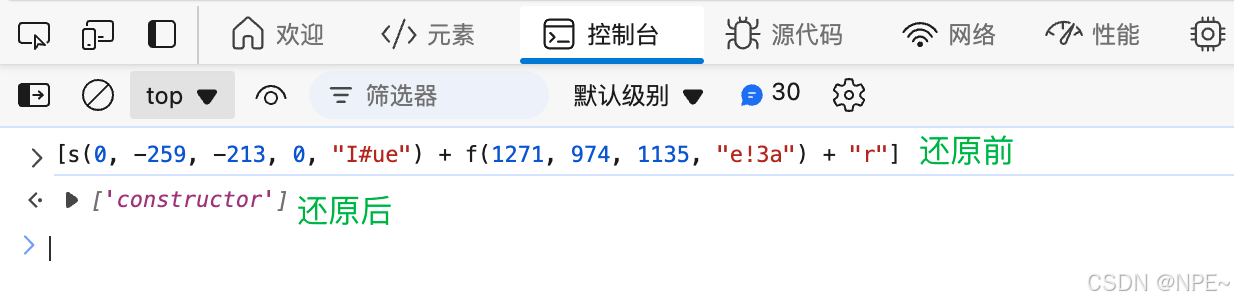

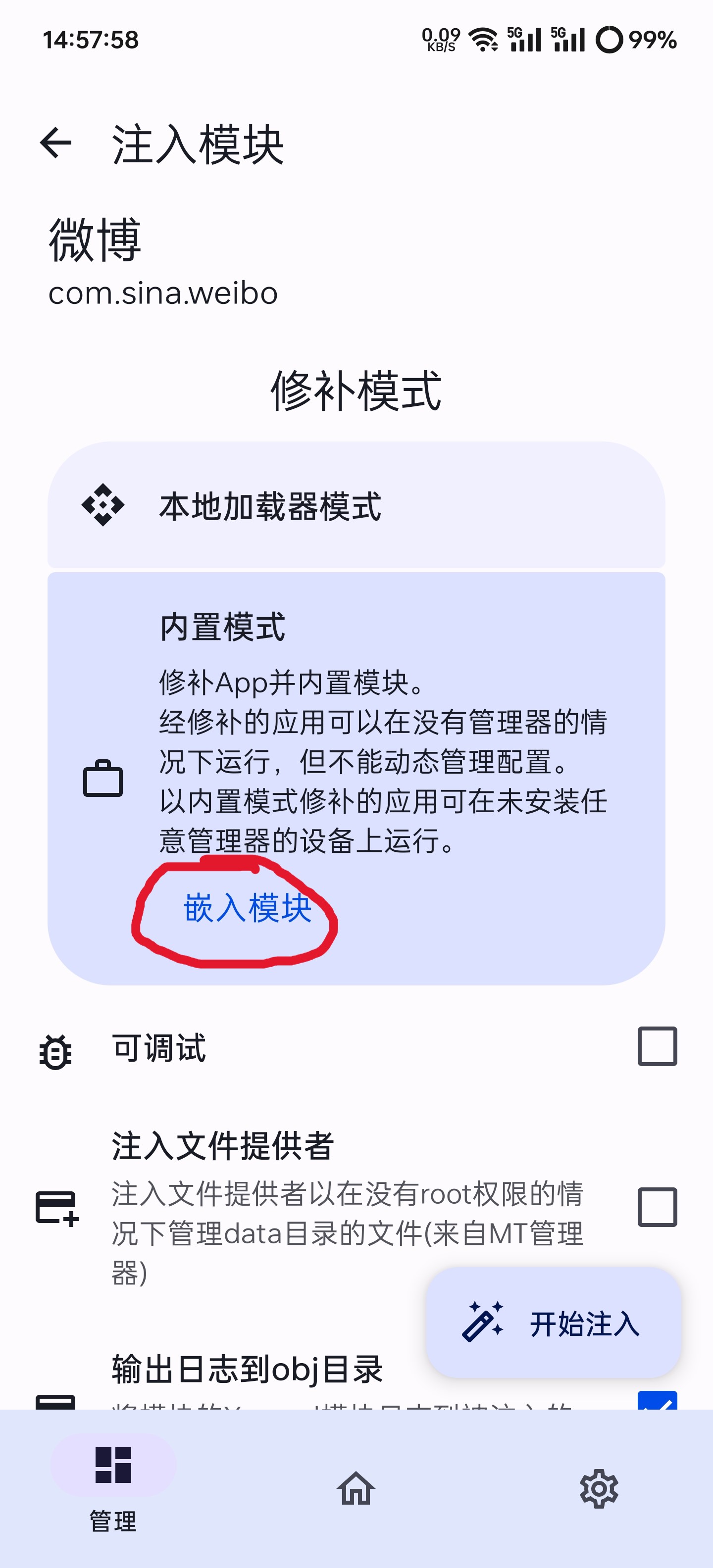

忽略执行的代码

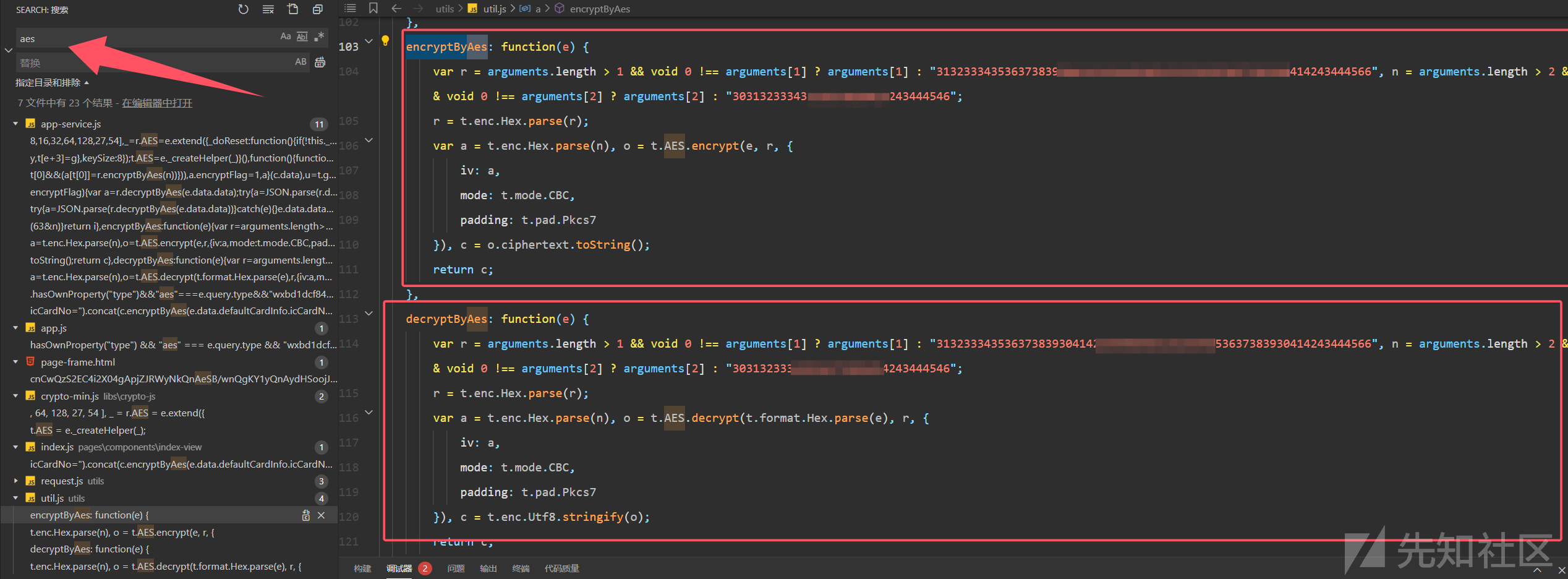

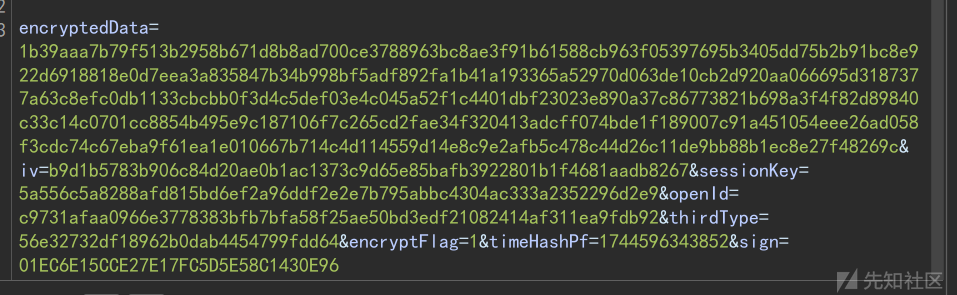

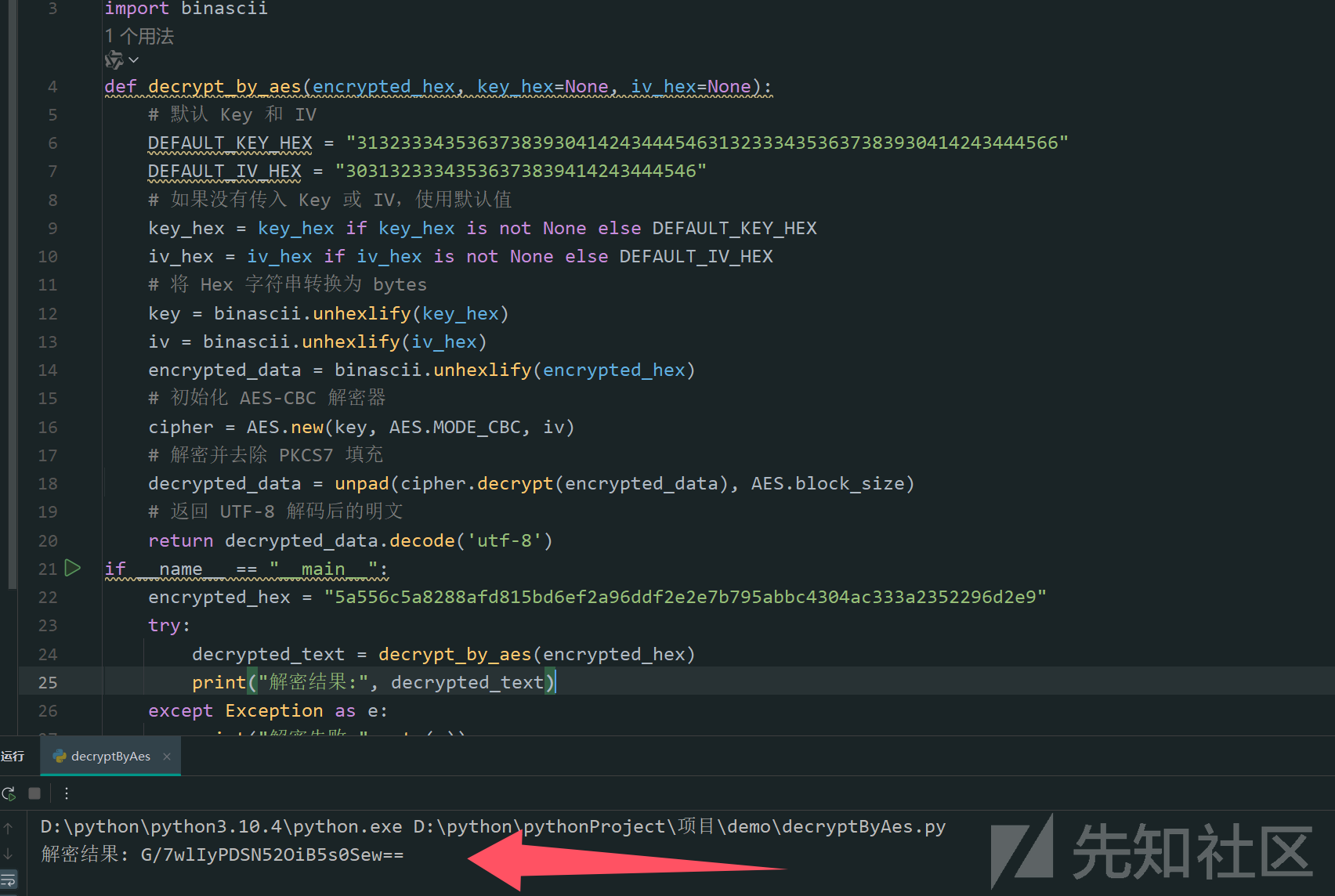

可以通过添加 add script ignore list 需要忽略执行代码行或文件,也可以达到禁止无限 debugger。 不过,我们可以通过将 debugger 改写成 Function (“debugger”)(); 的形式来应对,Function 构造器生成的 debugger 会在每一次执行时开启一个临时 js 文件。当然使用的时候,为了更加的安全,最好使用加密后的脚本。

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

(() => {

function ban() {

setInterval(() => {

Function("debugger")();

}, 50);

}

try {

ban();

} catch (err) {}

})();

// 加密后

eval(

(function (c, g, a, b, d, e) {

d = String;

if (!"".replace(/^/, String)) {

for (; a--; ) e[a] = b[a] || a;

b = [

function (f) {

return e[f];

},

];

d = function () {

return "w+";

};

a = 1;

}

for (; a--; )

b[a] && (c = c.replace(new RegExp("\b" + d(a) + "\b", "g"), b[a]));

return c;

})(

'(()=>{1 0(){2(()=>{3("4")()},5)}6{0()}7(8){}})();',

9,

9,

"block function setInterval Function debugger 50 try catch err".split(" "),

0,

{}

)

);

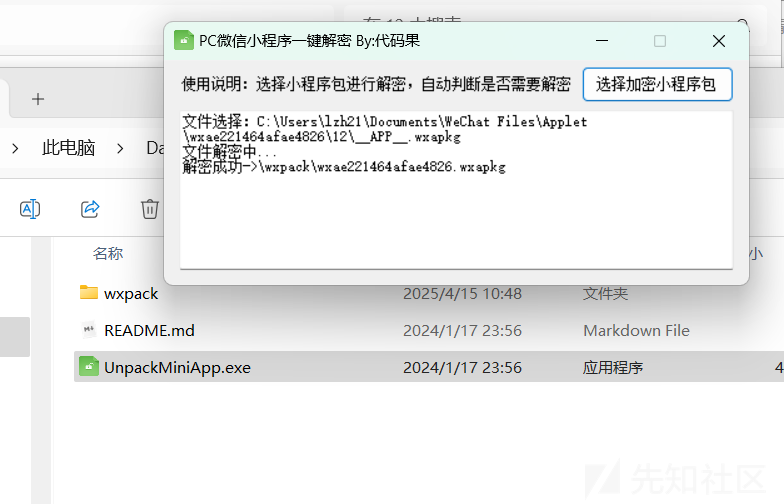

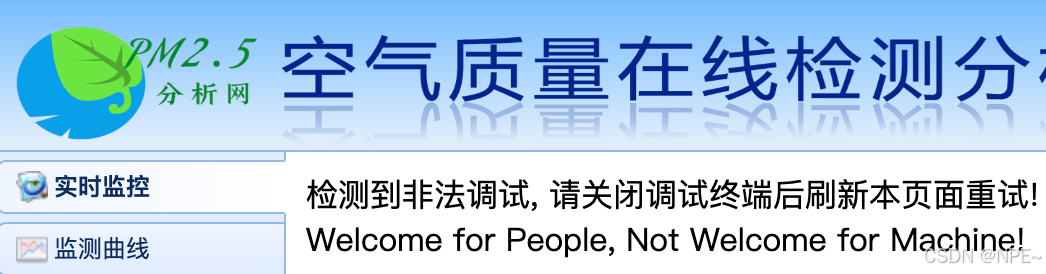

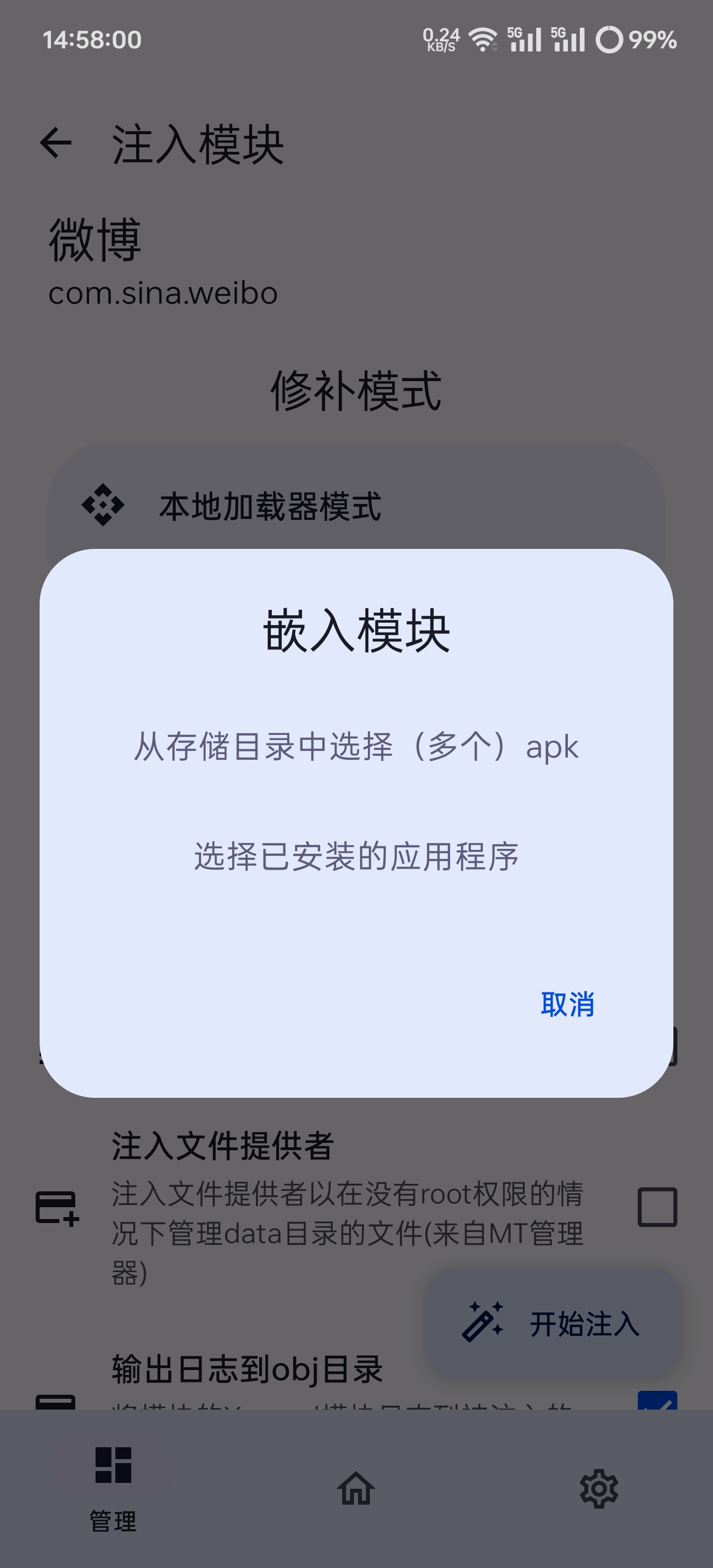

终极增强防调试

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

function block() {

if (

window.outerHeight - window.innerHeight > 200 ||

window.outerWidth - window.innerWidth > 200

) {

document.body.innerHTML = "检测到非法调试,请关闭后刷新重试!";

}

setInterval(() => {

(function () {

return false;

})

["constructor"]("debugger")

["call"]();

}, 50);

}

try {

block();

} catch (err) {}

})();

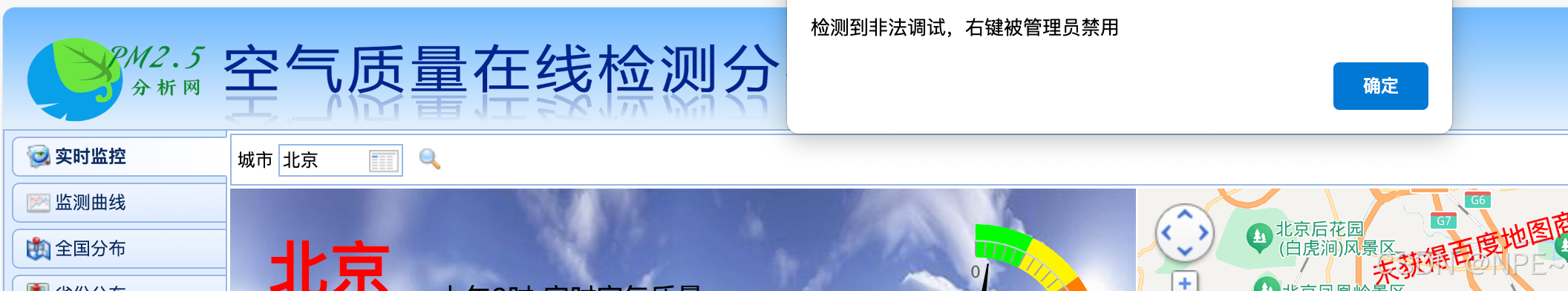

其他防调试技术

除此之外,我们还可以通过【禁止右键菜单】、【禁止 F12 快捷键】、【检测开发者工具】等手段来禁止调试。

禁止右键菜单

禁止右键菜单是目前比较常见的一种禁止调试的方法,因为浏览器默认右键菜单是可以调出开发者工具的。可以通过以下 JS 代码实现:

2

3

return false;

};这样一来,当用户在富文本编辑器的区域内右键时,就不会弹出菜单,从而避免了用户调出开发者工具的情况。

禁止 F12 快捷键

F12 快捷键是打开开发者工具的常用快捷键,禁止这个快捷键也是一种禁止调试的方法。可以通过以下 JS 代码实现:

2

3

4

5

if (e.keyCode === 123) {

return false;

}

};这样一来,当用户按下 F12 键时,就会被拦截,从而避免了用户打开开发者工具的情况。

检测开发者工具

还有一种方法是通过检测开发者工具是否打开来实现禁止调试的目的,可以通过以下 JS 代码实现:

2

3

4

5

if (typeof console.clear !== "undefined") {

location.reload();

}

}, 1000);这段代码会每隔 1 秒检测一次当前页面是否打开了开发者工具,如果发现开发者工具已经打开,则会刷新当前页面,从而避免用户使用开发者工具对页面进行调试。